La econometría ha sido, sin duda, una de las herramientas más poderosas en la caja de herramientas del economista moderno. Permite transformar intuiciones teóricas en modelos cuantificables, poner a prueba hipótesis y hacer proyecciones que informan políticas públicas y decisiones privadas. Sin embargo, como advertiría Nassim Nicholas Taleb, el abuso de las herramientas cuantitativas puede llevarnos a un estado de «ilusión de conocimiento» que oscurece más que ilumina. Quizás una de sus frases más fuertes está en su obra “El Cisne Negro”: “Un campo abominable que, si se le aplicara cualquier escrutinio científico, no existiría” (p. 338).

«Lo que se mide se gestiona», reza el mantra tecnocrático. Pero, ¿qué ocurre cuando lo que se mide está contaminado por supuestos erróneos, datos ruidosos o realidades que escapan al modelo lineal? En palabras de Taleb (2007), «la econometría a menudo confunde la ausencia de evidencia con evidencia de ausencia». Esto es especialmente peligroso en contextos donde la causalidad es difícil de establecer y las correlaciones pueden ser espurias.

Breve historia de la econometría: de la física de gases a los mercados financieros

La econometría, como disciplina formal, nació en el siglo XX, pero sus raíces se remontan al anhelo decimonónico de dar cientificidad a la economía. Inspirados por los éxitos de la física, muchos economistas quisieron trasladar el rigor matemático de las ciencias naturales a la comprensión de los fenómenos sociales.

Uno de los pioneros de esta idea fue Paul Samuelson, quien aplicó modelos de la física termodinámica a la economía. Su modelo de equilibrio económico general se basó en analogías con la física de gases: así como las moléculas tienen comportamientos agregados predecibles, los agentes económicos, en masa, podrían ser modelados con ecuaciones diferenciales. Esta traslación epistemológica dio lugar a una visión mecanicista de la economía que marcó profundamente el desarrollo de la econometría.

La fundación de la Econometric Society en 1930 y los trabajos de Trygve Haavelmo (Premio Nobel 1989) cimentaron la disciplina al establecer el marco probabilístico formal que hoy conocemos. Desde entonces, la econometría se ha expandido a todas las ramas de la economía: laboral, financiera, del desarrollo, ambiental, entre otras.

Las virtudes de la econometría: orden en el caos

Pese a las críticas, es justo reconocer que la econometría ha permitido avances extraordinarios en la comprensión de fenómenos económicos. Desde la estimación de la elasticidad precio de la demanda hasta la evaluación de impacto de políticas sociales, la econometría provee un lenguaje común para confrontar teorías con evidencia empírica. Su fuerza reside en la formalización, la claridad metodológica y la posibilidad de replicación.

Por ejemplo, el desarrollo de modelos de regresión múltiple ha permitido controlar por múltiples variables y avanzar en la identificación de relaciones causales. Técnicas como los modelos de variables instrumentales, regresiones discontínuas o diferencias en diferencias, han sido particularmente valiosas en estudios de política pública. El Premio Nobel de Esther Duflo y Abhijit Banerjee en 2019 ilustra cómo la econometría, cuando se aplica con rigurosidad y cuidado, puede generar conocimiento valioso para el diseño de intervenciones sociales efectivas.

Los riesgos de la sobreconfianza: cuando los modelos reemplazan el juicio

La crítica central de Taleb, y de muchos otros pensadores críticos, es que la econometría puede convertirse en una forma de dogma, una fé mal ubicada en los modelos como si fuesen representaciones fidedignas del mundo. Esta «epistemología del Excel» convierte a los supuestos en verdades, y a las salidas del software en evidencias incuestionables.

En The Black Swan, Taleb advierte que los modelos estadísticos convencionales subestiman los eventos raros y extremos. La distribución normal, asumida en muchas pruebas econométricas, descarta precisamente aquello que más importa en la historia económica: crisis financieras, revoluciones, colapsos tecnológicos. De allí su famosa frase: «El cisne negro no es la excepción, es la regla».

El fetichismo de la significancia estadística

Deirdre McCloskey ha sido una de las voces más insistentes en denunciar lo que llama el «fetichismo del valor-p». En su obra The Rhetoric of Economics, sostiene que la economía académica ha caído en una trampa metodológica: confundir significancia estadística con relevancia económica.

Un resultado que arroja un p-valor menor a 0.05 no es necesariamente importante desde el punto de vista de la política pública, y sin embargo, los incentivos académicos han llevado a una cultura de «p-hacking» donde se prueba y re-prueba hasta que el modelo «funciona». Esta práctica erosiona la credibilidad de los hallazgos y convierte a la econometría en una herramienta de retórica más que de descubrimiento.

Econometría para lo absurdo: predicciones risibles

La econometría también ha sido utilizada para intentar predecir lo impredecible. En los mercados financieros, por ejemplo, es común encontrar informes de bancos de inversión que ofrecen proyecciones del precio de acciones o commodities a 10 o 20 años plazo, utilizando modelos de regresión lineal simple basados en tendencias pasadas.

Un caso paradigmático fue el informe de Goldman Sachs que, en 2008, proyectaba que el precio del barril de petróleo superaría los 200 dólares en pocos años. El modelo, basado en la tendencia ascendente de los precios hasta ese momento, ignoraba totalmente los factores geopolíticos y macroeconómicos que terminaron empujando el precio a menos de 50 dólares durante la crisis financiera.

Otro ejemplo recurrente es el uso de econometría para predecir la tasa de cambio o el rendimiento del S&P500 a 10 años vista. Estos modelos, pese a estar calibrados con sofisticadas técnicas como GARCH o VAR, tienden a fallar sistemáticamente. Taleb ha sido muy crítico de este tipo de ejercicios: «Intentar predecir los precios del mercado financiero es como predecir los números de la ruleta con una regla» (Taleb, 2010).

La razón es simple: los modelos tienden a encontrar patrones en cualquier serie de datos, y siempre arrojarán una pendiente, un coeficiente y un p-valor. Como dijo una vez John Ioannidis: «La ciencia estadística puede hacer que cualquier cosa parezca cierta, si tienes suficientes datos y libertad para jugar con ellos».

La fragilidad de los supuestos

Edward Leamer, en su influyente artículo «Let’s Take the Con Out of Econometrics» (1983), sostiene que la econometría depende excesivamente de supuestos que rara vez son cuestionados: linealidad, independencia de errores, homocedasticidad, entre otros. Leamer propone un enfoque más exploratorio y menos dogmático, donde el investigador explicite la sensibilidad de sus resultados a distintas especificaciones del modelo.

Esta crítica se hace eco en las crisis de replicabilidad que han afectado tanto a la economía como a otras ciencias sociales. Cuando resultados publicados no pueden reproducirse al cambiar levemente los supuestos o la muestra, estamos ante una señal clara de que la econometría ha sido usada como una caja negra, y no como una herramienta transparente.

Ideología disfrazada de cientificidad

Ronald Coase, con su ironía habitual, afirmó que «si torturas los datos el tiempo suficiente, acabarán confesando lo que quieras». Esta frase resume una de las críticas más punzantes a la econometría: su uso como instrumento para legitimar posiciones ideológicas bajo el ropaje de la neutralidad científica.

La selección de variables, la forma funcional del modelo, la elección de la muestra y el enfoque empírico no son decisiones neutrales. Cada una está cargada de supuestos teóricos y valores implícitos. Pretender que un modelo es simplemente un «reflejo» de la realidad es ignorar la naturaleza construida del conocimiento empírico.

El problema de la endogeneidad del conocimiento

Robert Lucas criticó la incapacidad de los modelos econométricos tradicionales para incorporar cambios en las expectativas de los agentes. Su famosa «crítica de Lucas» sostiene que los parámetros estimados a partir de datos históricos no son invariantes frente a cambios de política. En otras palabras, si el gobierno cambia una regla, los agentes cambian su comportamiento, y por lo tanto, los modelos que intentan predecir sin tener en cuenta este cambio fallan estructuralmente.

Este argumento revela un límite fundamental de la econometría: su uso predictivo está limitado por la reflexividad de los sistemas sociales. A diferencia de las ciencias naturales, los seres humanos reaccionan a los modelos que intentan describirlos, lo que genera un juego infinito de retroalimentación.

Caminos hacia una econometría más humilde

Ante este panorama, la respuesta no es abandonar la econometría, sino reformular su rol en el quehacer económico. Se necesita una econometría menos dogmática, más transparente respecto de sus limitaciones y más dispuesta a dialogar con otras metodologías.

Una posibilidad es complementar el trabajo cuantitativo con análisis cualitativos, estudios de caso, etnografía económica e historia institucional. Otra es avanzar hacia enfoques bayesianos que expliciten las creencias previas del investigador. Y sobre todo, fomentar una cultura científica donde se valoren los resultados negativos, la replicabilidad y el juicio crítico.

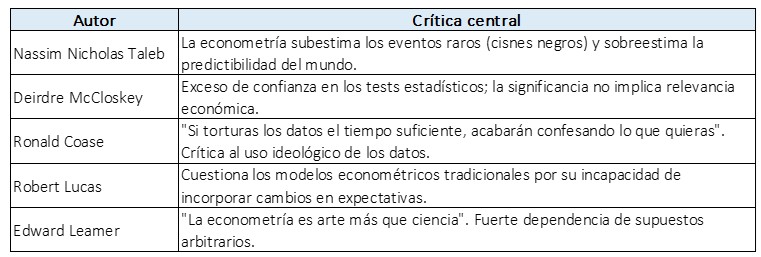

Cuadro resumen: críticas a la econometría

Conclusión: hacia una economía más autocrítica

La econometría no es el problema. El problema es su uso dogmático, su arrogancia tecnocrática y su desconexión de la complejidad del mundo real. Los modelos econométricos son intentos valiosos por simplificar, pero nunca deberían suplantar al juicio crítico ni a la experiencia empírica.

Reconocer las limitaciones de nuestras herramientas no es debilidad, sino una forma de sabiduría. Tal vez la verdadera ciencia comienza cuando dejamos de confundir nuestras hojas de cálculo con el mundo real, y empezamos a escuchar nuevamente a la realidad en toda su complejidad, ruido y ambigüedad.

Bibliografía:

- Taleb, N. N. (2007). The Black Swan: The Impact of the Highly Improbable. Random House.

- Taleb, N. N. (2010). The Bed of Procrustes: Philosophical and Practical Aphorisms. Random House.

- McCloskey, D. (1985). The Rhetoric of Economics. University of Wisconsin Press.

- Leamer, E. (1983). «Let’s Take the Con Out of Econometrics», The American Economic Review, Vol. 73, No. 1.

- Lucas, R. (1976). «Econometric Policy Evaluation: A Critique», Carnegie-Rochester Conference Series on Public Policy.

- Coase, R. H. (1994). Essays on Economics and Economists. University of Chicago Press.

- Banerjee, A., & Duflo, E. (2019). Good Economics for Hard Times. PublicAffairs.

- Samuelson, P. (1947). Foundations of Economic Analysis. Harvard University Press.

- Ioannidis, J. P. A. (2005). «Why Most Published Research Findings Are False», PLoS Medicine, Vol. 2, No.